Fala galera do mundo dos dados! Seguimos na missão do projeto de análise de dados com Airbyte e Metabase. Agora é hora de criar o pipeline de dados Airbyte com PostgreSQL! Depois de fazer o deploy do Airbyte com o Docker, agora é possível configurar o primeiro pipeline de dados.

Neste pipeline faremos o fluxo de dados com origem no Google Analytics e destino em um banco de dados PostgreSQL. A ideia é extrair os dados do Google Analytics Universal, que será descontinuado esse ano, então é hora de armazenar os dados históricos. E já contando um spoiler dos próximos capítulos, também construiremos um pipeline para extrair os dados do GA4 que será o substituto do Universal. Então, vamos às configurações necessárias.

Liberar Acesso a API do Google Analytics

Primeiramente será necessário a liberação de acesso a API do GA que é feita através do GCP (Google Cloud Platform). Na imagem abaixo a API que estamos liberando o acesso aos dados.

Agora já podemos configurar a origem dos dados no Airbyte.

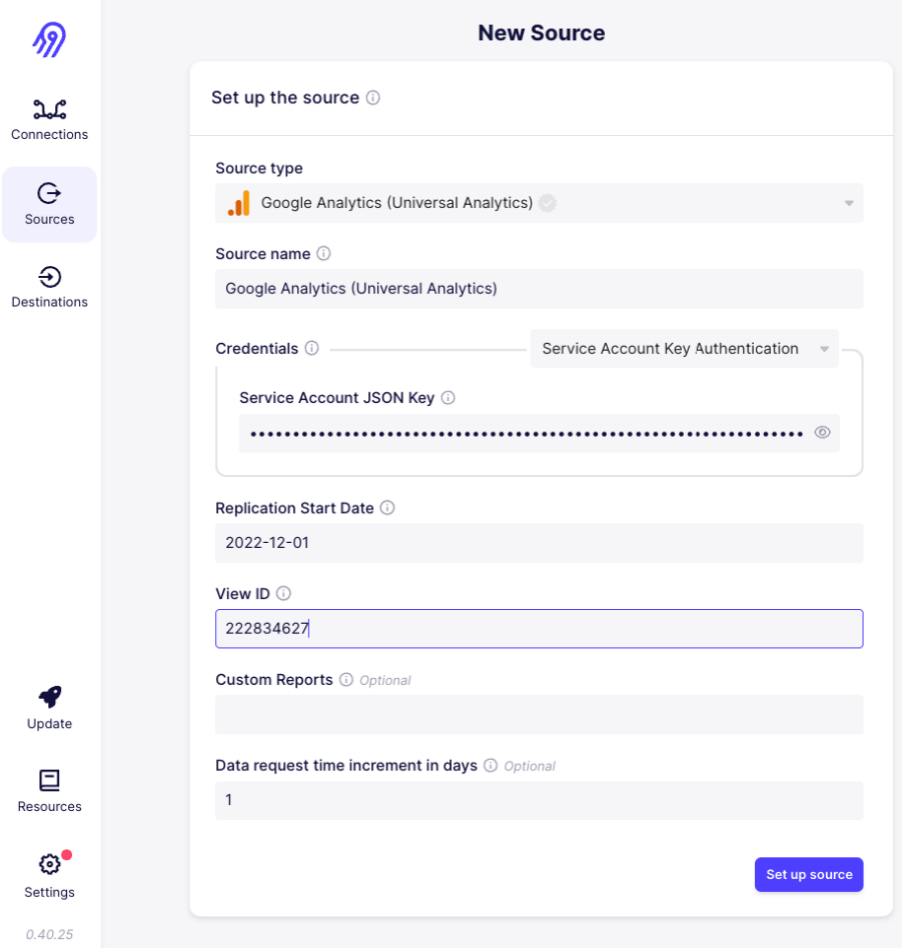

Configurar a Origem de Dados no Airbyte

Relembrando o acesso ao Airbyte, é através do endereço localhost:8000. Então podemos ir na opção Sources, que é onde configuramos as origens de dados. Em seguida criaremos uma New Source do tipo Universal Analytics conforme a imagem abaixo. E passamos a credencial de acesso, a data de início e o ID no GA.

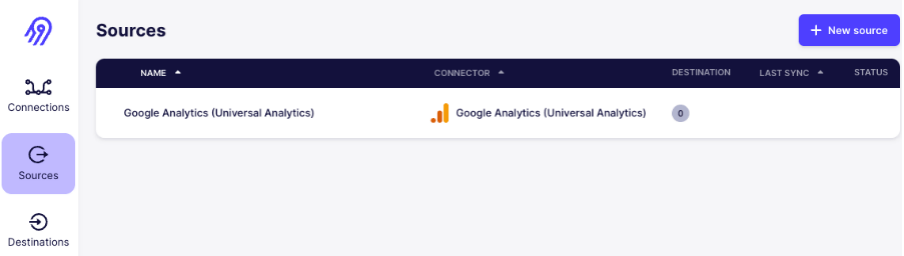

E então já temos a primeira origem de dados configurada, como está sendo exibido na imagem abaixo.

Origem configurada, a próxima etapa é realizar a configuração do destino.

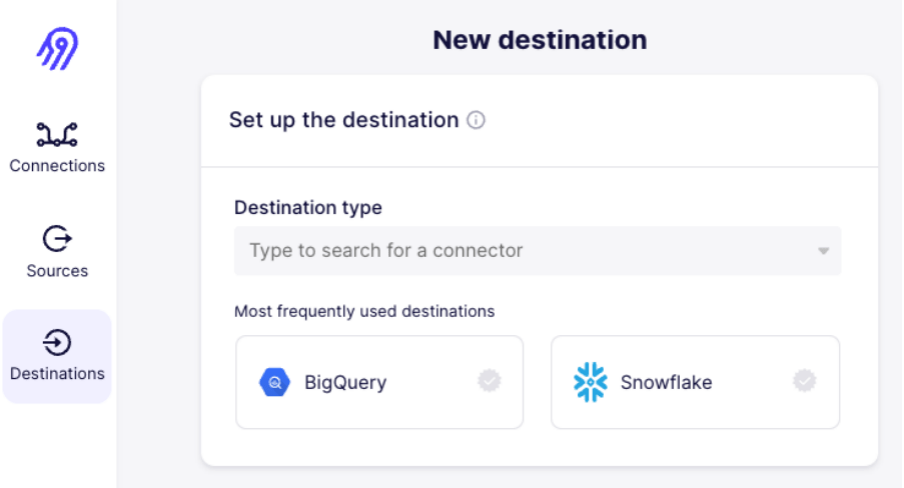

Configurar o Destino de Dados no Airbyte

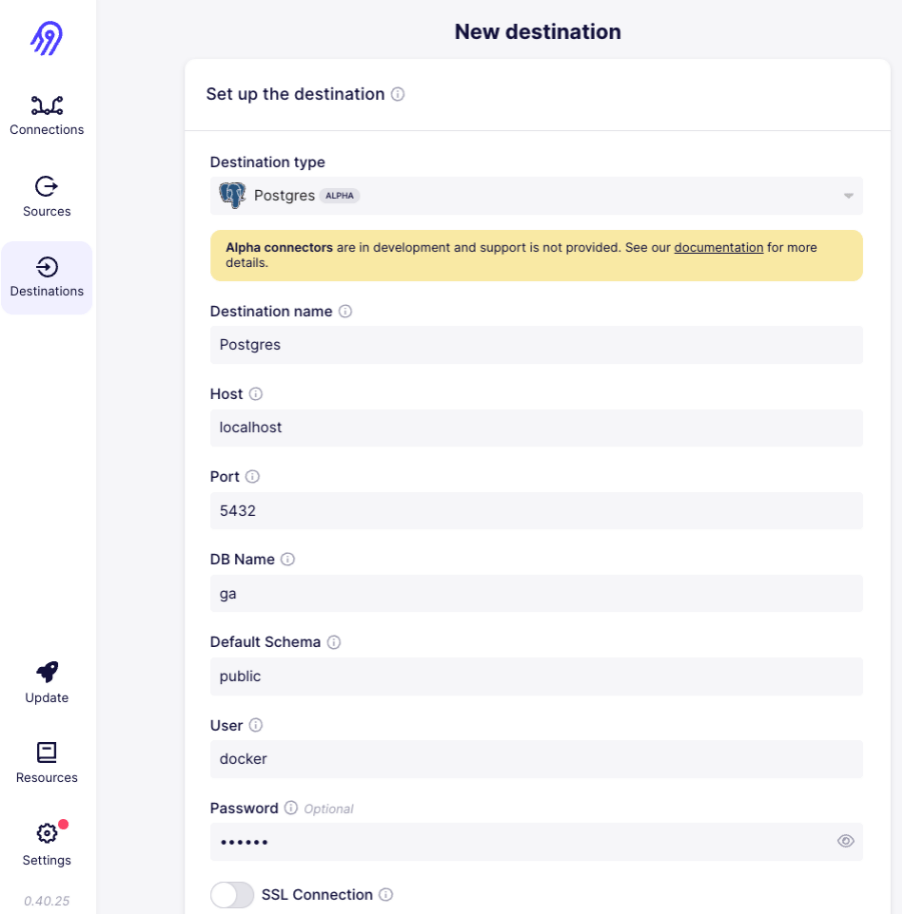

O destino dos dados, onde vamos persistir os mesmo, configuramos em Destinations, em seguida criamos uma New destination.

Agora, selecionamos o tipo, neste pipeline será o PostgreSQL. Precisamos dos parâmetros de acesso ao banco: host, porta, nome, esquema, usuário e senha. Conforme exemplo na imagem abaixo.

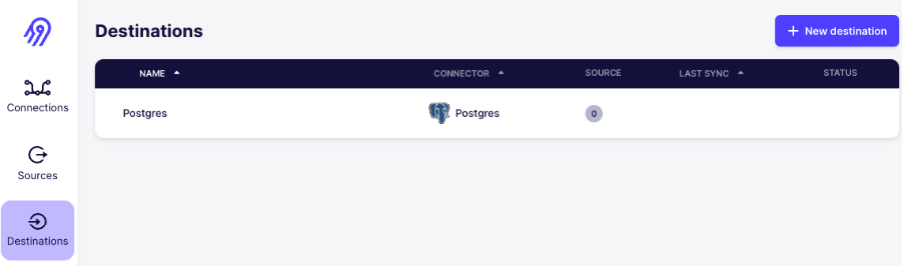

Logo, temos também o destino dos dados configurado! A imagem abaixo, lista os destinos de dados configurados.

Em seguida, só precisamos juntar as pontas, e ligar a origem ao destino necessário. E a criação das tabelas? Campos? Tipos de dados? O Airbyte vai fazer TUDO para nós 🚀!

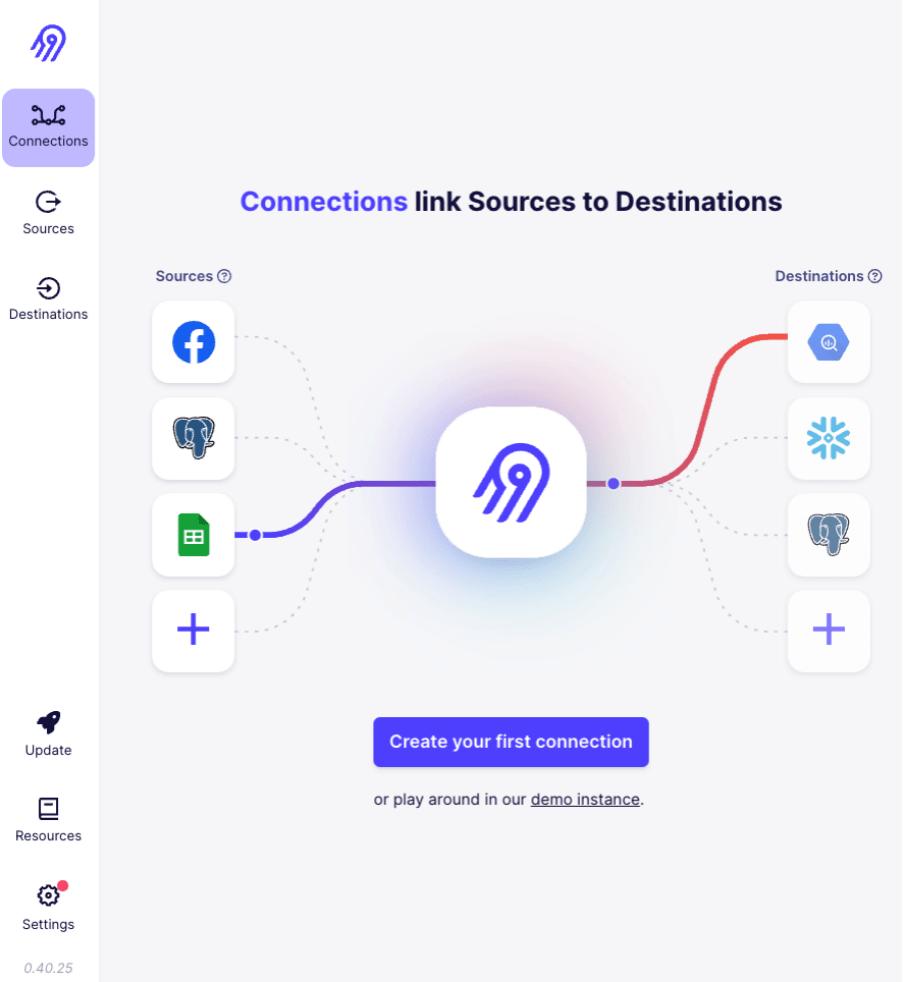

Criar a Conexão de Origem e Destino no Airbyte

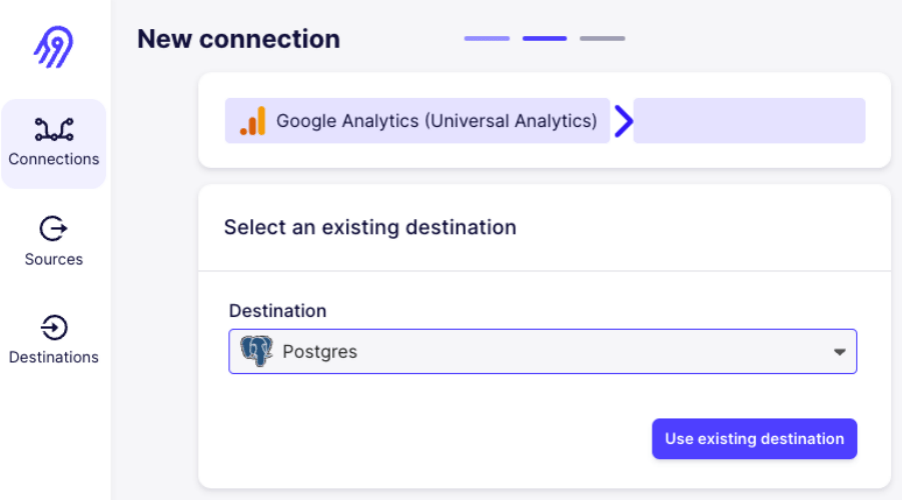

Chegou a hora das conexões, onde juntamos origem e destino dos dados. Para isso, temos a opção Connections, em seguida Create your first connection. Exatamente, nossa primeira conexão. Você confere tudo isso na imagem abaixo.

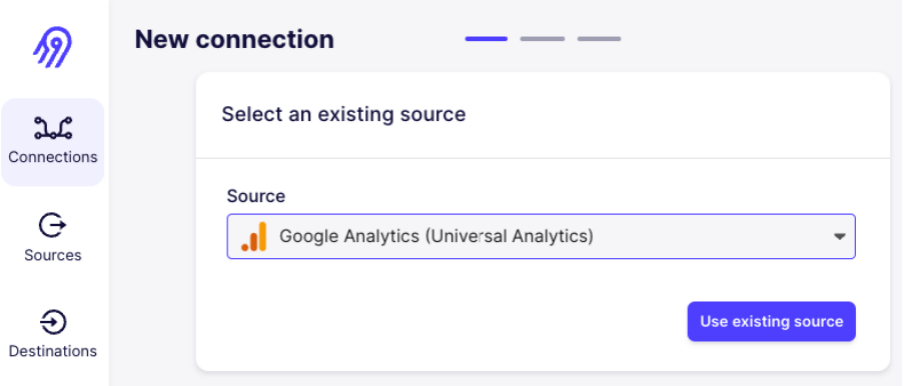

O primeiro passo é selecionar de onde vem os dados. Usaremos a origem do Universal Analytics criada anteriormente.

Origem selecionada, o próximo passo é escolher onde vamos armazenar os dados. Selecionaremos o destino Postgres criado anteriormente.

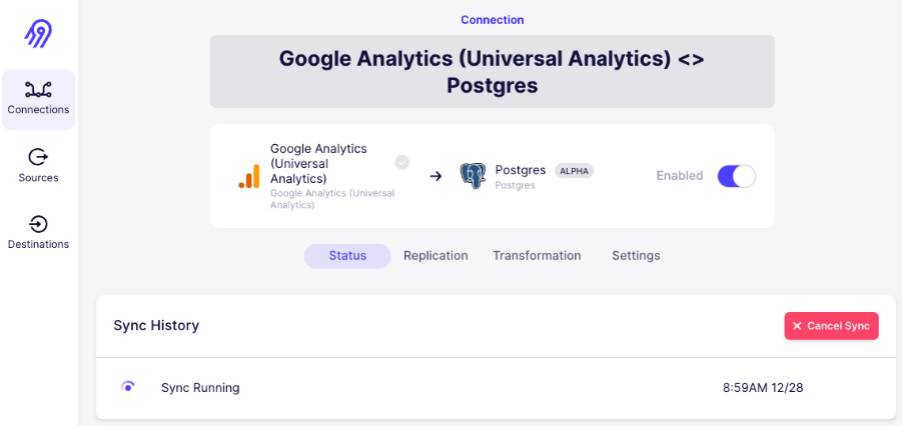

Para finalizar, faremos a sincronização dos dados. E então, a carga dos dados será realizada, levando da origem até o destino através do Airbyte.

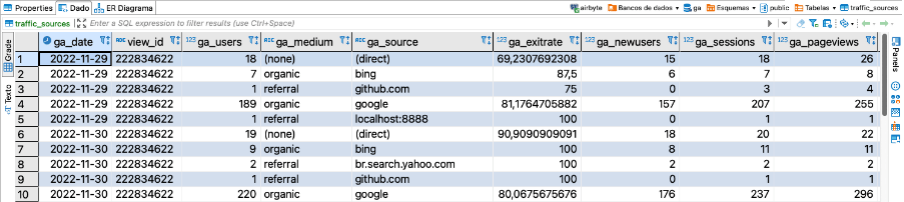

Após a carga finalizar, fazermos uma verificação em uma conexão direta com o banco utilizando a aplicação DBeaver.

Visualizar a Carga de Dados no PostgreSQL

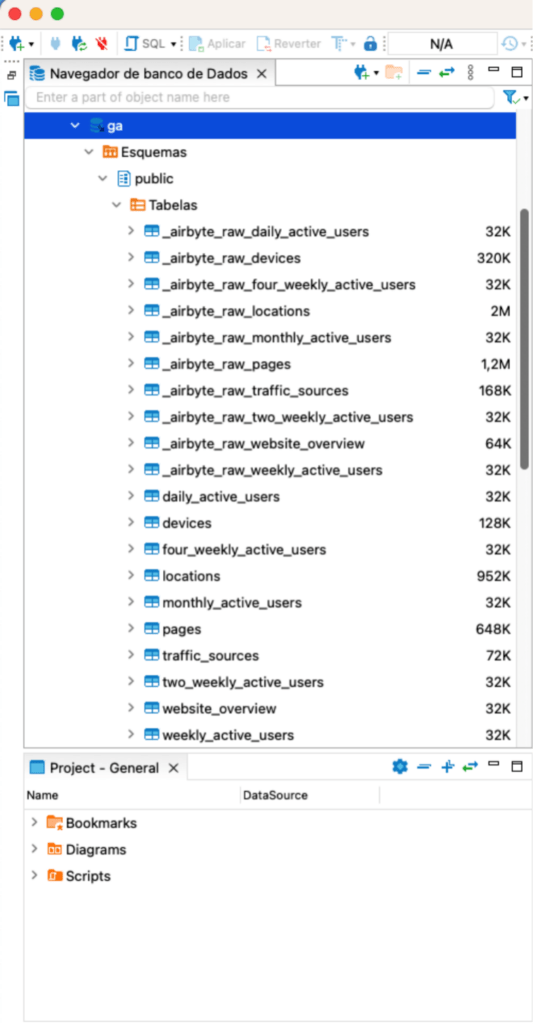

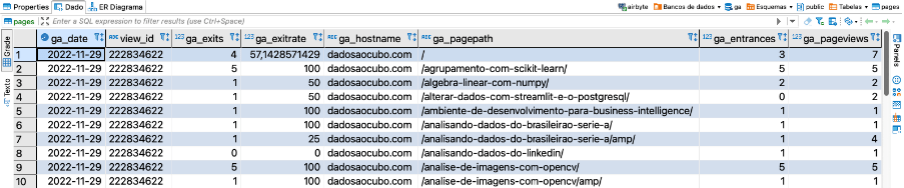

Para visualizar os dados da carga, acessar o banco ga. É possível ver na imagem abaixo as duas camadas criadas pelo Airbyte na carga, uma raw com os dados brutos e uma outra com os dados tratados. Tudo feito pelo próprio Airbyte!

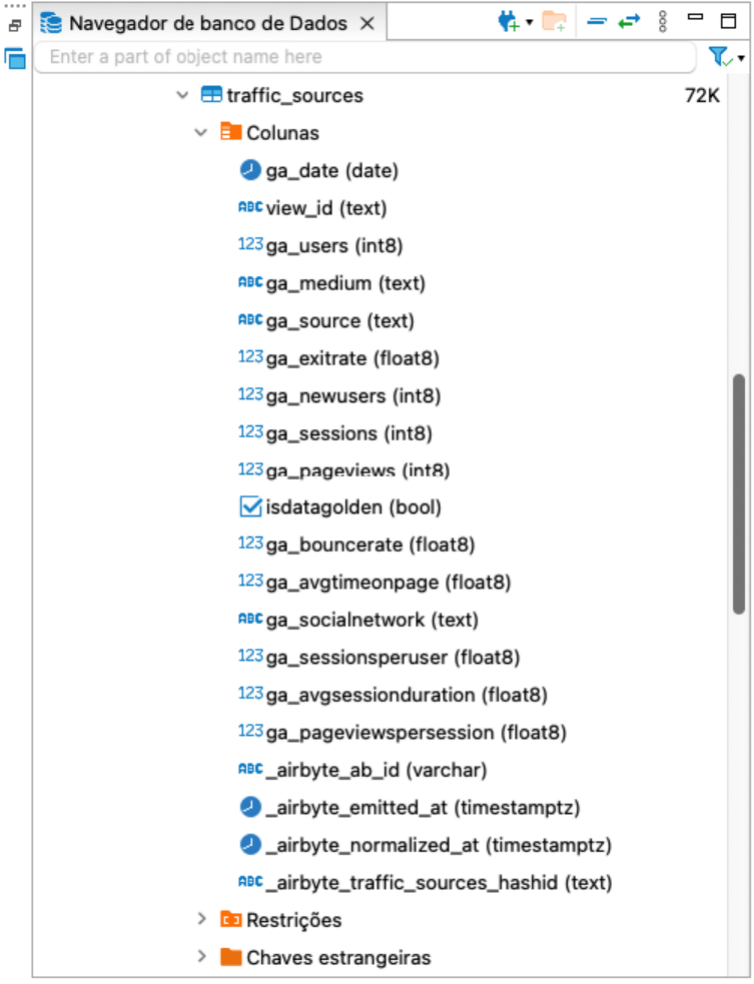

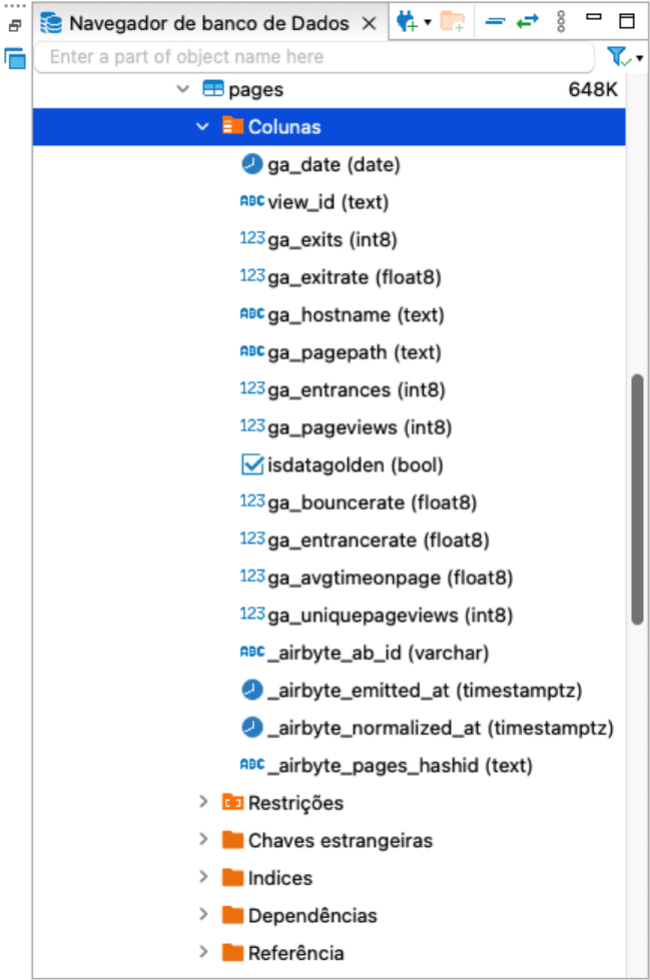

Selecionamos uma tabela para conferir as colunas e os tipos de dados, como podemos ver na imagem abaixo.

Em seguida, vamos dar um select nessa tabela para ver os registros das primeiras linhas.

Mais uma tabela para conferir campos e tipos de dados.

Mais uma vez, uma verificação para fazer um check da carga dos dados.

E então, parece que a carga foi realizada com sucesso! Muito bom esse tal de Airbyte, vai ajudar muito em cargas de dados padrões, como é o caso das plataformas de Analytics e Ads. E para novas cargas nesse pipeline?

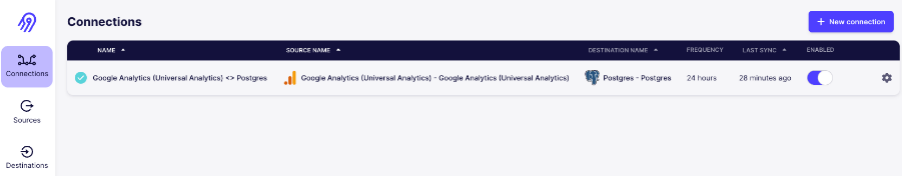

Conexão do Airbyte com o PostgreSQL

Com o pipeline criado, temos a conexão configurada para realizar as próximas cargas. Na imagem abaixo é possível ver todas as conexões existentes, bem como informações sobre a atualização dos dados. A primeira criada aqui leva os dados do GA para um banco de dados PostgreSQL com a super ajuda do Airbyte.

E assim finalizamos o primeiro pipeline de dados com o Airbyte. Espero que goste do conteúdo e que ele seja útil. Um abraço e até a próxima!

Conteúdos ao Cubo

Se você curtiu o conteúdo, lá no Dados ao Cubo tem muito mais. Então, deixo algumas sugestões de conteúdos que você pode encontrar por lá, sempre falando sobre o mundo dos dados.

- Conectar Banco de Dados MySQL com Python

- Introdução à Gramática dos Gráficos com plotnine

- Métodos de Classificação para Classes Desbalanceadas

- Estatística Descritiva Univariada

- Modelagem de Dados para Business Intelligence

- Análise de Dados: Detecção de Fraude de Cartão de Crédito

- Ingestão de Dados via API com Python

- Série de Automatização de Tarefas com Python

Finalizo com um convite para você ser Parceiro de Publicação Dados ao Cubo, escrever o próximo artigo e ter divulgação para toda a comunidade de dados no LinkedIn.

Apaixonado por dados e tecnologia ❤️ , criando soluções com dados 📊 📈 , desde 2015, sempre buscando tornar os processos orientados! Com formação em Engenharia da Computação 💾 , MBA Gestão da Informação e Business Intelligence e Especialização em Data Science.

Também atuo como professor na área de dados. Nas horas vagas crio modelos de Machine Learning 🤖 com Python em desafios do Kaggle e escrevo no Dados ao Cubo sobre o mundo dos dados 🎲 !

Compartilhando conhecimentos sempre 🚀